Author: Devi Parikh and Kristen Grauman

Atributos Relativos

Vencedor Marr Prize (Melhor Prêmio de Papel), ICCV 2011

�Quem no arco-íris pode desenhar a linha onde a tonalidade violeta termina e a tonalidade de laranja começa? Distinguidamente, vemos a diferença das cores, mas onde exatamente o primeiro se mistura no outro? Então, com sanidade e insanidade.�

�Herman Melville, Billy Budd

[papel] [dados] [código] [demos] [slides] [conversa (video)] [poster]

Abstrato

Motivação

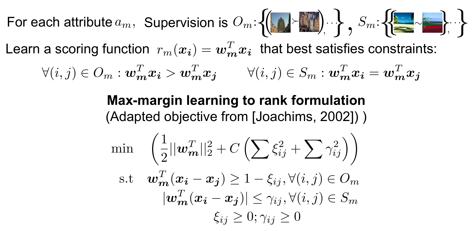

Os atributos binários são restritivos e podem não ser naturais. Nos exemplos acima, enquanto se pode caracterizar a imagem na parte superior esquerda e superior direita como natural e artificial, o que você descreveria a imagem no topo do centro? A única maneira significativa de caracterizá-lo é em relação às outras imagens: é menos natural do que a imagem à esquerda, mas mais do que a imagem à direita.

Proposta

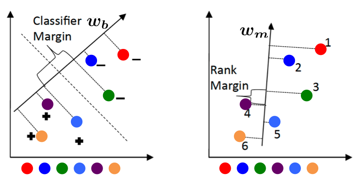

Abordagem

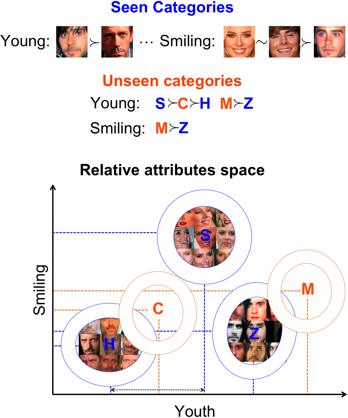

- categorias totais N: S seen categorias (imagens associadas estão disponíveis) + U unseen categorias (não há imagens disponíveis para essas categorias)

- S seen As categorias são descritas em relação entre si através de atributos (nem todos os pares de categorias precisam estar relacionados para todos os atributos)

- U unseen as categorias são descritas em relação a (um subconjunto de) categorias vistas em termos de (um subconjunto de) atributos.

Em primeiro lugar, treinamos um conjunto de atributos relativos usando a supervisão fornecida no seen categorias. Esses atributos também podem ser pré-treinados a partir de dados externos. Em seguida, construímos um modelo generativo (gaussiano) para cada um seen categoria usando as respostas dos atributos relativos às imagens do seen categorias. Em seguida, inferimos os parâmetros dos modelos generativos de unseen categorias, utilizando suas descrições relativas em relação a seen categorias. Uma visualização da abordagem simples que empregamos para isso é mostrada abaixo:

Uma imagem de teste é atribuída à categoria com a máxima probabilidade.

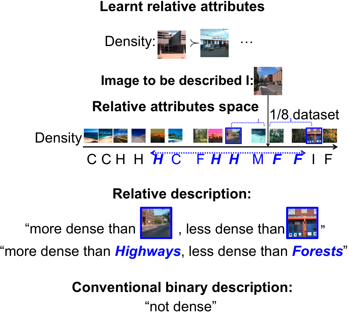

Como visto acima, além de descrever uma imagem relativa a outras imagens, nossa abordagem também pode descrever uma imagem relativa a outras categorias, resultando em uma descrição puramente textual. Claramente, as descrições relativas são mais precisas e informativas do que a descrição binária convencional.

Experimentos e resultados

Realizamos experiências em dois conjuntos de dados:

(1) Reconhecimento de cena ao ar livre (OSR) contendo 2688 imagens de 8 categorias: costa C, forest F, highway H, inside-city I, mountain M, open-country O, street S e tall-building T. Usamos os recursos de gist para representar as imagens.

(2) Um subconjunto do Base de dados de rosto de figuras públicas (PubFig) contendo 772 imagens de 8 categorias: Alex Rodriguez A, Clive Owen C, Hugh Laurie H, Jared Leto J, Miley Cyrus M, Scarlett Johansson S, Viggo Mortensen V e Zac Efron Z. Usamos recursos de cores e cores coloridos para representar as imagens.

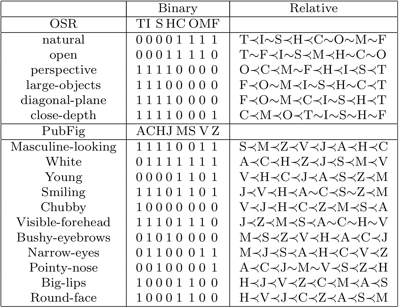

A lista de atributos utilizados para cada conjunto de dados, juntamente com as anotações de atributo binário e relativo, são mostradas abaixo:

Exemplo de descrições binárias de imagens, bem como descrições relativas a categorias são mostradas abaixo:

| Imagem | Descrições binárias | Descrições relativas |

|

não natural não aberto perspectiva |

mais natural do que o tallbuilding, menos natural do que a floresta mais aberto do que alto, menos aberto do que a costa mais perspectiva do que edifício alto |

|

não natural não aberto perspectiva |

mais natural do que a insidecidade, menos natural do que a rodovia mais aberto do que a rua, menos aberto do que a costa mais perspectiva do que rodovia, menos perspectiva do que insidecidade |

|

natural aberto perspectiva |

mais natural do que o alto, menos natural do que a montanha mais aberto do que a montanha menor perspectiva do que o campo aberto |

|

White not Smiling VisibleForehead |

mais Branco do que AlexRodriguez mais Sorridente do que JaredLeto, menos Sorridente do que ZacEfron mais VisibleForehead do que JaredLeto, menos VisibleForehead do que MileyCyrus |

|

Branco não Sorrindo não VisibleForehead |

mais Branco do que AlexRodriguez,

menos Branco do que MileyCyrus menos Sorridente do que HughLaurie mais VisibleForehead do que ZacEfron, menos VisibleForehead que MileyCyrus |

|

não Jovem BushyEyebrows RoundFace |

mais Jovem do que CliveOwen,

menos Jovem do que ScarlettJohansson mais BushyEyebrows do que ZacEfron, menos BushyEyebrows do que AlexRodriguez mais RoundFace do que CliveOwen, menos RoundFace do que ZacEfron |

Nós provemos o aprendizado os atributos relativos e suas previsões para os dois conjuntos de dados usados em nosso artigo: Reconhecimento de cena ao ar livre (OSR) e um subconjunto do Base de dados de rosto de figuras públicas (PubFig).

Conjunto de dados de atributos de rosto relativo. Ele contém anotações para 29 atributos relativos em 60 categorias do Base de dados de rosto de figuras públicas (PubFig).

Modificamos a implementação RankSVM de Olivier Chappelle para treinar atributos relativos com restrições de similaridade. Nosso código modificado pode ser encontrado aqui.

Se você usa o nosso código, cite o seguinte artigo:

D. Parikh e K. Grauman

Atributos Relativos

Conferência Internacional sobre Visão de Computador (ICCV), 2011.

Demonstrações de várias aplicações de atributos relativos podem ser encontradas aqui. Uma descrição desses aplicativos pode ser encontrada nos documentos aqui.

Conferência Internacional sobre Visão de Computador (ICCV), 2011. (Oral)

Marr Prize (Melhor Prêmio Papel) vencedor

[slides] [conversa (video)] [poster] [demos]

Os seguintes são outros documentos que usam atributos relativos:

A. Biswas e D. Parikh

Aprendizagem ativa simultânea de classificadores & Atributos via Feedback relativo

Conferência IEEE sobre visão computacional e reconhecimento de padrões (CVPR), 2013

[página e dados do projeto] [poster] [demo]

A.

Parkash e

D. Parikh

Atributos para comentários do classificador

Conferência européia sobre visão computacional (ECCV), 2012 (Oral)

[slides] [conversa (video)] [página e dados do projeto] [demo]

A.

Kovashka, D. Parikh

e K. Grauman

WhittleSearch: Pesquisa de imagens com comentários relativos de atributos

Conferência IEEE sobre visão computacional e reconhecimento de padrões (CVPR), 2012

[página do projeto] [poster]

[demo]

D. Parikh, A. Kovashka, A.

Parkash e K. Grauman

Atributos relativos para comunicação entre humanos e máquinas aprimoradas (Documento convidado)

Conferência AAAI sobre Inteligência Artificial (AAAI), 2012 (Oral)